EU・AI法の成立 – 来るべきAI規制への備え –

EUにおけるAI法の成立に関するニュースレターを発行いたしました。こちらの内容は、以下のリンクよりPDF版でもご覧いただけます。

EU・AI法の成立

– 来るべきAI規制への備え –

2024年4月

One Asia Lawyers Tokyo Office

ニューヨーク州法弁護士 友藤 雄介

パートナー弁護士(日本法) 國分 吾郎

アソシエイト弁護士(日本法) 山本 博人

1.はじめに

2024年3月13日、人工知能に関する規則法(Harmonised Rules on Artificial Intelligence (AI法)) [1]が欧州議会で賛成523票、反対46票、棄権49票で承認されました。AI法は現在、言語学者を含めた最終確認作業中ではあるものの、最終的には議会終了までに採択される見込みです。 AI法はAIに関する世界的に見ても初めての包括的な法律と言われており、世界のAIガバナンスに広範な影響を与える可能性があります。欧州連合(EU)はこの分野で最初の法令を作成することで、AI規制のモデルを推進しようとしているものと考えられます。本ニュースレターでは、本法について解説いたします。

2.概要

(1) 発効時期と適用範囲

AI法は、官報に掲載されてから20日後に発効し、発効から24ヵ月後に全面的に適用されます。ただし、禁止行為(第5条)を含む第1条~第5条(Title I及びII)は発効から6ヶ月後、後述するLimited Riskにおける通知義務を含む第30条~39条(Title III Chapter 4)及び罰則規定(Title X)等は、発効から12ヶ月後、高リスクAIシステムに関する義務は36ヶ月後に適用される等の例外があります(第85条3項)。

AI法は、EU域内または第三国で設立されたAIシステムのプロバイダー[2]および配備者[3](AIシステムによって生成された出力がEU域内で使用される場合等)、およびEU域内に所在する影響を受ける者、さらにはAIシステムの輸入者・ディストリビューターに適用されます(第2条1項)。

ただし、AI法は、純粋に個人的な非専門的活動の過程でAIシステムを使用する自然人には適用されません(第2条5c項)。また、軍事、防衛、国家安全保障の目的のみに使用されるAIシステムや、科学的研究開発のみを目的として開発されたAIシステムには適用されません(第2条3項・5a項)。さらに、フリーライセンスやオープンソースライセンスの下でリリースされたAIシステムについては、第6条の高リスクAIシステム、第5条の禁止事項、第52条の透明性義務の対象として分類されない限り、適用されません(第2条5g項)。

(2) リスクベース・アプローチ

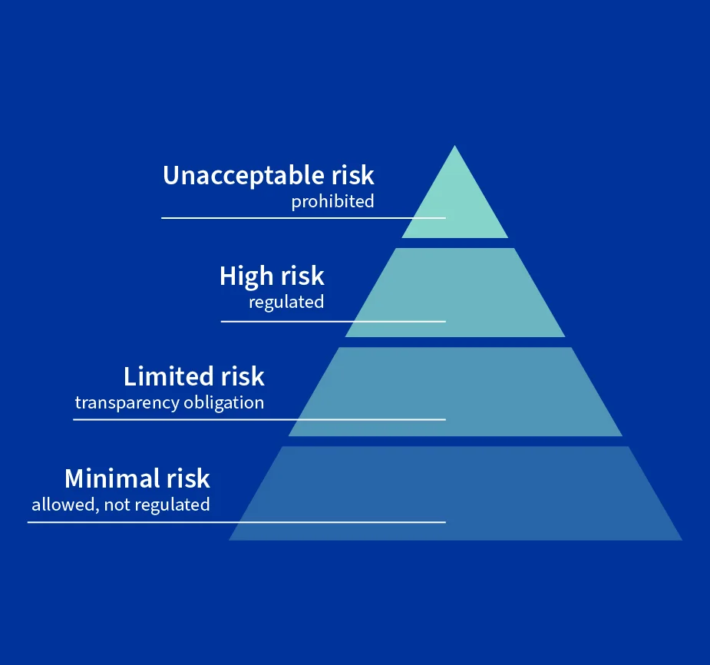

AI法は、リスクベースのアプローチに従っています。下の図のように、AIシステムのリスクが高ければ高いほど、規則は厳しくなる様に設計されております。

(欧州委員会(EU)ホームページからhttps://www.consilium.europa.eu/en/your-online-life-and-the-eu/)

具体的にはAI法では、以下の4つのリスクに分類の上、以下の通り規制しています。

- A. 非許容リスク(Unacceptable Risk): 禁止

- B. 高リスク(High Risk): 規制

- C. 低リスク(Limited Risk): 透明性の確保

- D. 最小リスク(Minimal Risk): 規制なし

以下、詳述いたします。

(3) A. 非許容リスク(Unacceptable Risk)

AI法第5条は、A. 非許容リスク(Unacceptable Risk)として、AIに関する主に以下の行為を禁止しています。

- サブリミナル的、操作的、欺瞞的なテクニックを使用して、個人または集団の行動を実質的に歪曲するAIシステムの利用等

- 個人または集団の脆弱性(例えば、年齢、障害、社会的・経済的状況によるもの)を悪用するAIシステムの利用等

- 人種、政治的思想、労働組合への加盟の有無、宗教的・哲学的信条、または性的指向を推測するために、生体認証(バイオメトリクス)データに基づいて自然人を分類するAIシステムの利用等

- 特定の自然人またはその集団全体に対する不利益等につながる様な、社会的スコアリングを用いた社会的行動や個人の特徴等による分類するAIシステムの利用等

- 法執行のための、公共のアクセス可能な空間におけるリアルタイムの遠隔生体認証の利用

- 個人の特徴に基づいて犯罪を犯すリスクを予測するAIシステムの利用等

- 顔認識データベースを作成または拡張するための、インターネットまたはCCTVの顔画像の非標的スクレイピングするAIシステムの利用等

- 職場や教育機関における感情認識を行うAIシステムの利用等(ただし、医療上または安全上の理由(パイロットの疲労度の監視など)は除く)

(4) B. 高リスク(High Risk)

a. 分類

AI法第6条第2項及びAnnex IIIは、高リスク(High Risk)のAIシステムを例えば以下の分野で使用されるAIシステムとしています。

- 生体認証(遠隔での生体識別、生体認証による分類、感情認識を含む)

- 重要なデジタルインフラ(道路交通、水・ガス・暖房・電気の供給)の管理・運営システム

- 教育及び職業訓練(入学、成績評価、試験の監視等での運用等)

- 雇用・労務管理(採用、昇進、解雇、評価、配属等)

- 必要不可欠な民間・公的サービスの享受(公的給付等の受給資格の評価、クレジットスコアの評価、緊急電話の評価、初動サービスの派遣、緊急医療患者の優先治療システムの確立、生命保険および健康保険のリスク評価と価格設定の実施)、

- 法執行(ポリグラフ(いわゆる嘘発見器)及び類似のツールとしての使用、犯罪行為または犯罪被害者となる危険性の評価、犯罪の捜査または起訴の過程における証拠の信頼性の評価、性格特性および過去の犯罪行動の評価、犯罪の発見、捜査または起訴の過程におけるプロファイリングの実施)、

- 移民、亡命、国境管理(ポリグラフ及び類似のツールとしての使用、ある人物がもたらす安全保障上・健康上等のリスクの評価、亡命・ビザ・滞在許可の申請の審査、国境管理にて人物の検出・認識・特定)、

- 司法プロセス及び民主政治プロセス(司法当局による事実および法律の調査・解釈、具体的な事実に対する法律の適用の支援、選挙結果や投票行動への影響の付与)。

上記の分野が高リスク(High Risk)として規定されているものの、自然人の健康、安全、または基本的権利に重大な危害を及ぼす危険性がなければ、AIシステムは、高リスクとはみなされない旨が規定されています(AI法第6条2a)。具体的には、AIシステムが、過去の人間の活動の結果を改善する場合や、過去の人間の活動の評価を行う場合であって、過去の行動に取って代わったり影響を与えたりしない意思決定パターンを検出する場合や、上記の高リスクのケースのいずれかの準備作業を実行する場合を指します。

b. 規制

高リスクとみなされるAIシステムは、リスク管理システムを導入して設計・開発されなければならず、技術的な文書化、ログによる自動的な記録管理、人間による監視も必要となります。また、適切なレベルの精度、堅牢性、サイバーセキュリティを備えていなければなりません。更に、高リスクAIシステムには、簡潔、完全、正確かつ明確な情報を提供する使用説明書が添付されていなければならず、これらの説明書は、利用者が容易にアクセスでき、理解できるものでなければなりません。[4]

人間による監視としては例えば以下が含まれ、これらは、第14条第4項に概説されています。

- (a) AIシステムの能力と限界の理解(及びその上での監視)

- (b) ユーザーがAIシステムの出力に過度に依存した場合に起こりうる「自動化バイアス」のリスクを認識

- (c) 他のツールや方法を用いた上でのAIシステムの出力の正しい解釈

- (d) AIシステムの不使用の決定、またはAIシステムの出力の無視、上書き、または取消し

- (e) 「停止」ボタンまたは同様の手順を使用してAIシステムの動作に介入した上での、システムの安全な停止

c. 高リスクAIシステムのプロバイダーと配置者の義務

高リスクのAIシステムのプロバイダー及び配置者は、以下を行わなければなりません(第16条(但し一部を除く))。

- 身元と連絡先の明示

- 品質管理システムの導入

- 技術文書,品質マネジメントシステムに関する文書を,国家の所轄官庁が自由に入手できるような形での保管

- AI法第43条に基づく、上市前または使用開始前のAIシステムの適合性評価[5]

- AI法の遵守に関する宣言書(「EU適合宣言書」)の作成[6]

- EUのデータベースに自社と自社のシステムの登録[7]、

- 関連データを積極的かつ体系的に収集、文書化、分析するモニタリングシステムの確立[8]

- 国内の市場監視当局に重大な事故の報告(第62条)[9]

またこれに加えて配置者は、AI法第29条に基づく特定の義務も負います。AIシステムを監督する自然人に、必要な能力、訓練、権限、支援があることを保証しなければなりません(第29条1a)。また、配置者は、一部のAIシステムの導入を除いて、基本的人権に対する影響のアセスメントの実施も事前に義務付けられています。(AI法第29条a)。

(5) C. 低リスク(Limited Risk)

前述のEUによるリスクの分類に関わらず、AI法上、明確に低リスク (Limited Risk) に当たる文言は規定されておりません。ただ、自然人と直接対話することを意図した AI システムは、低リスクのAIに該当すると考えられており、この場合透明性の義務を負います。透明性の義務として、AIシステムに関して、原則として当該自然人が AI システムと対話していることを確実に認識できるように設計・開発されなければなりません(第52条)。

(6) D. 最小リスク(Minimal Risk)

前述のEUによるリスクの分類に関わらず、AI法上、明確に最小リスクに当たる文言は規定されておりません。ただ、純粋に個人的な非専門的活動の過程でAIシステムの使用 (第2条5c項)がAI法の適用対象外とされていることから、これが最小リスクに該当するものと考えられます。

3.罰則規定

AI法は、違反企業に対する罰則規定として罰金が規定されています。非許容リスクのAI慣行の違反に対しては最大3500万ユーロまたは前会計年度における全世界の年間売上高の7%のいずれか高い方の罰金が課されます。また、その他の義務違反に対しては1500万ユーロまたは同3%のいずれか高い方が。更に、不正確な情報の提供に対しては750万ユーロまたは1%となります(AI法第71条)。

なお、いかなる自然人または法人は、第三者のAI法の不遵守に関して、関連する市場監視当局に苦情を提出することができるとされています。また、配置者が、法的効果を生じさせたり、個人の健康、安全、基本的権利に重大な影響を与えたりする高リスクAIシステムの出力に基づいて決定を下す場合、当該個人は、意思決定過程におけるAIシステムの役割や、決定に寄与した主要な要因について、明確かつ意味のある説明を求める権利を有するとされています(AI法第68c条)。

4.イノベーションを支える施策

AI法は、イノベーションを促進し、革新的なAIシステムの開発、訓練、試験、検証を容易にするために、市場投入やサービス開始前の限られた期間に、各国当局が設置するいわゆる規制のサンドボックスを利用した開発を推進しています。

AI規制のサンドボックス外の実環境におけるAIシステムのテストは、国内市場監視当局の承認と、影響を受ける個人のインフォームド・コンセントを条件として、リスクの高いAIシステムのプロバイダーが実施することができるとされています(AI法第54条a)。

5.結論

AI法はリスクベース・アプローチを中心に据えており、AIシステムのリスクや関係者の種別を区別し、それぞれに規制を課しています。ただ一方、前述の通り、個人的または非業務的なAIシステムの使用は規制の対象外となります。

なお、本AI法に関連して、欧州議会自由権委員会共同報告者であるドラゴス・トゥドラチェ氏は「AIは、民主主義、教育モデル、労働市場、戦争遂行方法の核心にある社会契約について再考を迫ると考えられており」、「AI法は旅の終わりではなく、むしろテクノロジーを中心に構築された新しい統治モデルの出発点である」と延べています。このことから、今後も本AI法が実態に合わせて改正されていくものと考えられます。

[1] AI法の規定(英文): https://www.europarl.europa.eu/doceo/document/TA-9-2024-0138_EN.pdf

[2] 「提供者(Provider)」とは、AIシステムを開発し、または開発させ、有償・無償を問わず、自己の名称または商標の下に市場に投入し、またはサービスを開始する自然人または法人、公的機関、代理店、その他の団体をいう(AI法3条2項)。

[3] 「配置者(deployer)」とは、AIシステムが個人的な非専門的活動のために使用される場合を除き、自然人または法人、公的機関、代理店、その他の機関がその権限の下でAIシステムを使用することを意味する(AI法第3条第4項)。

[4] 第9条等

[5] 適合性評価には、品質マネジメントシステムと技術文書の評価が含まれる。手順はAI法の付属書VIと付属書VIIに概説されている。

[6] EU適合宣言書に記載すべき内容の概要は、AI法の付属書Vに規定されている。

[7] 法執行、移民、亡命、国境管理の分野におけるリスクの高いAIシステムを除き、EUのデータベースは一般に公開され、ユーザーフレンドリーなものとなる(AI法第60条3項)。

[8] 市販後モニタリング制度は、欧州委員会がひな型を定める市販後モニタリング計画書に基づくものとする(AI法61条3項)。

[9] 「重大インシデント」とは、直接的または間接的に人の死亡または人の健康への重大な損害、重要インフラの管理・運用の重大かつ不可逆的な中断、基本的権利の保護を目的とする連邦法に基づく義務の違反、財産または環境への重大な損害につながる、AIシステムの事故または誤作動を意味する(AI法3条44項)。